Adversarial Attacks: Wie Künstliche Intelligenz gehackt werden kann und was Unternehmen tun können

Adversarial Attacks: Wie Künstliche Intelligenz gehackt werden kann und was Unternehmen tun können

In der heutigen digitalen Ära ist Künstliche Intelligenz (KI) aus vielen Geschäftsprozessen nicht mehr wegzudenken. Ob in der Automobilindustrie, im Gesundheitswesen oder in der Sicherheitsüberwachung – KI-Systeme optimieren Abläufe, verbessern die Effizienz und ermöglichen innovative Lösungen. Doch je mehr Unternehmen auf KI setzen, desto größer werden auch die Bedrohungen für diese Systeme. Eine besonders ins Auge stechende Gefahr stellen Adversarial Attacks dar – gezielte Manipulationen, die darauf abzielen, KI-Modelle zu täuschen und ihre Funktionalität zu beeinträchtigen. In diesem Beitrag beleuchten wir, was Adversarial Attacks sind, wie sie funktionieren und welche Maßnahmen Unternehmen ergreifen können, um sich dagegen zu schützen.

Was sind Adversarial Attacks?

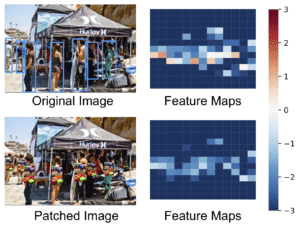

Adversarial Attacks sind gezielte Angriffe auf KI-Systeme, bei denen kleine, oft kaum wahrnehmbare Veränderungen an den Eingabedaten vorgenommen werden. Diese Veränderungen zielen darauf ab, die KI-Modelle zu verwirren und falsche Ergebnisse zu erzeugen. Ein häufiges Beispiel findet sich in der Bildklassifikation: Ein kleines Muster, das auf ein Bild aufgebracht wird, kann dazu führen, dass das KI-System ein Objekt falsch erkennt oder gar nicht mehr erkennt.

Diese Angriffe sind besonders gefährlich, weil sie oft mit minimalen Veränderungen einhergehen, die für das menschliche Auge kaum erkennbar sind. Dennoch können sie erhebliche Auswirkungen auf die Leistung und Zuverlässigkeit von KI-Systemen haben.

Die Studie: Adversarial Attacks auf moderne Objekterkennungssysteme

Eine aufschlussreiche Untersuchung zu diesem Thema ist die Studie „Making an Invisibility Cloak: Real World Adversarial Attacks on Object Detectors„. Diese Forschung beleuchtet die Anfälligkeit moderner Objekterkennungssysteme gegenüber Adversarial Attacks und zeigt auf, wie diese Angriffe in der Praxis funktionieren und welche Konsequenzen sie für Unternehmen haben können.

Ziele der Studie

Die Forscher hatten folgende Hauptziele:

- Übertragbarkeit von Angriffen: Untersuchung, wie gut Adversarial Attacks auf verschiedene Modelle, Klassen und Datensätze übertragbar sind.

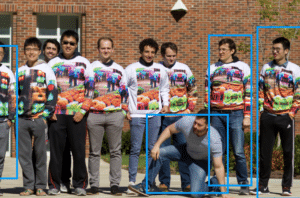

- Realwelt-Anwendungen: Entwicklung und Test von physischen Angriffen, beispielsweise durch gedruckte Muster auf Kleidungsstücken oder Postern.

- Bewertung der Effektivität: Quantifizierung der Erfolgsraten dieser Angriffe unter verschiedenen Bedingungen und gegen unterschiedliche Erkennungssysteme.

- Identifikation von Schwachstellen: Herausarbeiten, welche Faktoren die Effektivität der Angriffe beeinflussen.

Methodik

Die Forscher verwendeten YOLOv2, ein bekanntes Objekterkennungsmodell, um spezifische Muster zu trainieren, die die Erkennung von Objekten wie Personen verhindern oder erschweren. Diese Muster wurden sowohl digital als auch physisch getestet, um die Robustheit und Übertragbarkeit der Angriffe zu bewerten. Dabei wurden verschiedene Umgebungsfaktoren wie Beleuchtung, Kamerawinkel und Abstand berücksichtigt, um realistische Testbedingungen zu schaffen.

Ergebnisse der Studie

Die Ergebnisse der Studie zeigen, dass Adversarial Attacks tatsächlich in der Lage sind, moderne Objekterkennungssysteme signifikant zu stören. Insbesondere das Modell YOLOv2 zeigte eine hohe Anfälligkeit gegenüber den entwickelten Angriffsmustern. Durch das Aufbringen der Muster konnten die Forscher die Erkennungsrate von Personen drastisch senken, ohne dass dies für das menschliche Auge offensichtlich war.

Effektivität in der digitalen Welt

In digitalen Simulationen konnten die Angriffe die Average Precision (AP), ein Maß für die Genauigkeit der Objekterkennung, um bis zu 70% reduzieren. Dies verdeutlicht, wie effektive diese Angriffe sein können, wenn die Bedingungen kontrolliert sind.

Physische Angriffe

Auch in realen Umgebungen, etwa durch gedruckte Poster oder auf Kleidung aufgebrachte Muster, konnten die Studienautoren die Erkennungssysteme erheblich beeinträchtigen. Zwar war die Effektivität in der physischen Welt geringer als in der digitalen Simulation, dennoch stellten die Ergebnisse eine ernsthafte Bedrohung dar, insbesondere in sicherheitskritischen Bereichen wie der Zugangskontrolle oder dem autonomen Fahren.

Risiken für Unternehmen

Die Erkenntnisse dieser Studie werfen ein Schlaglicht auf die Sicherheitslücken von KI-Systemen, die Unternehmen betreiben. Besonders in Branchen, in denen die Erkennung und Klassifikation von Objekten lebenswichtig sind, können Adversarial Attacks schwerwiegende Konsequenzen haben.

Manipulation von Sicherheitskameras

Angreifer könnten gezielt Muster anbringen, um ihre Anwesenheit vor Überwachungssystemen zu verbergen. Dies könnte in sensiblen Bereichen wie Lagerhäusern, Produktionsstätten oder Bürogebäuden zu einem erheblichen Sicherheitsrisiko führen.

Autonomes Fahren

In der Automobilindustrie könnten solche Angriffe die Funktionsweise von autonomen Fahrzeugen beeinträchtigen. Fehlfunktionen in der Objekterkennung könnten dazu führen, dass Fahrzeuge Hindernisse nicht erkennen oder falsch identifizieren, was potenziell zu Unfällen führen kann.

Zugangskontrollsysteme

Unternehmen, die auf KI-gesteuerte Zugangskontrollsysteme setzen, könnten durch Adversarial Attacks ihre Sicherheitsmaßnahmen umgehen. Dies stellt ein erhebliches Risiko dar, insbesondere für Unternehmen mit wertvollen oder sensiblen Daten.

Maßnahmen zur Absicherung gegen Adversarial Attacks

Angesichts der wachsenden Bedrohung durch Adversarial Attacks ist es für Unternehmen unerlässlich, proaktive Maßnahmen zu ergreifen, um ihre KI-Systeme zu schützen.

Implementierung von Erklärbarer KI (Explainable AI)

Erklärbare KI (XAI) ermöglicht es, die Entscheidungen von KI-Systemen besser zu verstehen und nachzuvollziehen. Durch Transparenz in den Entscheidungsprozessen können Anomalien oder verdächtige Muster schneller erkannt und untersucht werden.

Regelmäßige Sicherheitsüberprüfungen

KI-Modelle sollten kontinuierlich auf Schwachstellen getestet und aktualisiert werden. Dies umfasst sowohl Software-Updates als auch die Überprüfung der Trainingsdatensätze, um sicherzustellen, dass keine manipulierten Daten injiziert wurden.

Einsatz von Robusteren Algorithmen

Die Entwicklung und Implementierung von robusteren Algorithmen ist entscheidend, um KI-Systeme widerstandsfähiger gegen Adversarial Attacks zu machen. Dies kann durch den Einsatz von Modellen erreicht werden, die speziell dafür entwickelt wurden, solche Angriffe zu erkennen und abzuwehren.

Schulung und Sensibilisierung der Mitarbeiter

Mitarbeiter sollten regelmäßig geschult werden, um die Bedeutung von KI-Sicherheit zu verstehen und potenzielle Bedrohungen frühzeitig zu erkennen. Ein informierter Mitarbeiterstab kann wesentlich dazu beitragen, Sicherheitslücken zu schließen. Wir als innFactory AI Consulting bieten ihnen regelmäßig sowohl die Ausbildung zum KI-Beauftragten an, als auch begleiten wir sie von Beginn an mit ihren KI-Herausforderungen.

Best Practices für den Schutz vor Adversarial Attacks

Neben den oben genannten Maßnahmen gibt es eine Reihe von Best Practices, die Unternehmen implementieren sollten, um ihre KI-Systeme zu schützen:

- Diversifizierung der Modelle: Durch den Einsatz verschiedener KI-Modelle in einem System kann die Wahrscheinlichkeit verringert werden, dass ein einzelner Adversarial Attack das gesamte System kompromittiert.

- Datenvalidierung: Eine gründliche Überprüfung der Eingabedaten kann helfen, manipulierte Daten zu erkennen und zu blockieren.

- Anomalieerkennung: Systeme zur Erkennung von Anomalien können ungewöhnliche Muster identifizieren, die auf einen möglichen Angriff hinweisen.

- Verschlüsselung sensibler Daten: Die Verschlüsselung von Daten, die an KI-Systeme übermittelt werden, schützt vor unbefugtem Zugriff und Manipulation.

- Regelmäßige Audits: Durch regelmäßige Audits können Unternehmen Schwachstellen identifizieren und beheben, bevor sie ausgenutzt werden können. In Sicherheitkritischen Systemen sollten Sie die ISO42001 zusätzlich zur ISO27001 in Betracht ziehen.

Fazit

Die Studie „Making an Invisibility Cloak“ unterstreicht die Gefahren von Adversarial Attacks für moderne KI-Systeme. Trotz fortschrittlicher Technologien wie Objekterkennungssystemen zeigen die Ergebnisse, dass selbst bewährte Modelle wie YOLO anfällig für gezielte Angriffe sein können. Diese Erkenntnisse verdeutlichen die Dringlichkeit, in die Sicherheit und Robustheit von KI-Systemen zu investieren.

Für Manager und Führungskräfte mittelständischer Unternehmen bedeutet dies, dass die Implementierung von KI-Lösungen nicht nur ein technisches, sondern auch ein strategisches Anliegen ist. Erklärbare KI, kontinuierliche Sicherheitsüberprüfungen und der Einsatz robuster Algorithmen sind essenziell, um die Integrität und Zuverlässigkeit von KI-Anwendungen zu gewährleisten.

Obwohl das untersuchte Modell YOLOv2 bereits vor über vier Jahren veröffentlicht wurde, bleibt die Demonstration seiner Anfälligkeit ein wichtiger Hinweis auf die Notwendigkeit fortlaufender Verbesserungen in der KI-Sicherheit. Unternehmen müssen proaktiv handeln, um ihre Systeme vor potenziellen Bedrohungen zu schützen und gleichzeitig die Vorteile von KI-Technologien voll auszuschöpfen.

Kontaktieren Sie uns, um mehr darüber zu erfahren, wie wir Ihnen helfen können, Ihre KI-Strategie sicher und zukunftsfähig zu gestalten.

Tobias Jonas

Tobias Jonas, M.Sc. ist Mitgründer und Co-CEO der innFactory AI Consulting GmbH. Er ist ein führender Innovator im Bereich Künstliche Intelligenz und Cloud Computing. Als Co-Founder der innFactory GmbH hat er hunderte KI- und Cloud-Projekte erfolgreich geleitet und das Unternehmen als wichtigen Akteur im deutschen IT-Sektor etabliert. Dabei ist Tobias immer am Puls der Zeit: Er erkannte früh das Potenzial von KI Agenten und veranstaltete dazu eines der ersten Meetups in Deutschland. Zudem wies er bereits im ersten Monat nach Veröffentlichung auf das MCP Protokoll hin und informierte seine Follower am Gründungstag über die Agentic AI Foundation. Neben seinen Geschäftsführerrollen engagiert sich Tobias Jonas in verschiedenen Fach- und Wirtschaftsverbänden, darunter der KI Bundesverband und der Digitalausschuss der IHK München und Oberbayern, und leitet praxisorientierte KI- und Cloudprojekte an der Technischen Hochschule Rosenheim. Als Keynote Speaker teilt er seine Expertise zu KI und vermittelt komplexe technologische Konzepte verständlich. Wer über die neuesten Entwicklungen im Bereich KI informiert bleiben möchte, sollte ihm auf LinkedIn folgen.

Werde jetzt Teil unserer KI-Community.

Der Newsletter „Quo vadis KI?“ ist die Quelle für aktuelle Trends und Entwicklungen in der Künstlichen Intelligenz.